Предвзятые Алгоритмы: Как Скрытые Уклоны Меняют Жизни

Мы живем в эпоху алгоритмов. Они определяют, какую рекламу мы видим, какие новости читаем, и даже, получим ли мы работу или кредит. Но что происходит, когда эти алгоритмы оказываются предвзятыми? Как эти скрытые уклоны влияют на группы риска, и что мы можем с этим сделать? Давайте разберемся вместе.

В этой статье мы погрузимся в мир алгоритмической предвзятости, рассмотрим примеры из реальной жизни и обсудим возможные решения; Мы расскажем о том, как машинное обучение, которое лежит в основе многих алгоритмов, может невольно воспроизводить и усиливать существующие социальные неравенства.

Что такое Алгоритмическая Предвзятость?

Алгоритмическая предвзятость возникает, когда алгоритм систематически выдает несправедливые или дискриминационные результаты. Это происходит из-за предвзятых данных, используемых для обучения алгоритма, или из-за того, как сам алгоритм был разработан. Важно понимать, что алгоритмы не являются нейтральными; они отражают ценности и предубеждения тех, кто их создает и обучает.

Предвзятость может проявляться в разных формах. Например, алгоритм распознавания лиц может лучше работать для людей с определенным цветом кожи, чем для других. Или алгоритм, используемый для оценки кредитоспособности, может несправедливо отказывать в кредитах людям, живущим в определенных районах.

Причины Алгоритмической Предвзятости

Существует несколько основных причин, по которым алгоритмы становятся предвзятыми:

- Предвзятые данные: Если данные, используемые для обучения алгоритма, содержат предвзятости, алгоритм неизбежно их унаследует.

- Неполные данные: Если данные не представляют все группы населения, алгоритм может хуже работать для тех, кто недостаточно представлен.

- Предвзятые алгоритмические решения: Дизайнеры алгоритмов могут невольно внести предвзятости в процесс разработки, например, выбирая метрики, которые благоприятствуют определенным группам.

- Отсутствие разнообразия в командах разработчиков: Если команды разработчиков не представляют разнообразие общества, они могут не заметить предвзятости, которые очевидны для людей из других групп.

Примеры из Реальной Жизни

Давайте рассмотрим несколько конкретных примеров, чтобы лучше понять, как алгоритмическая предвзятость проявляется в реальном мире:

- Системы оценки рисков в уголовном правосудии: Эти системы используются для оценки вероятности того, что обвиняемый совершит новое преступление. Исследования показали, что некоторые из этих систем предвзяты против афроамериканцев, чаще ошибочно определяя их как лиц с высоким риском.

- Инструменты найма на работу: Многие компании используют алгоритмы для отбора резюме и проведения первичных собеседований. Эти алгоритмы могут быть предвзяты против женщин или людей из определенных этнических групп, если они обучались на данных, отражающих историческую дискриминацию.

- Алгоритмы социальных сетей: Алгоритмы, определяющие, какой контент мы видим в социальных сетях, могут усиливать существующие предрассудки и создавать «эхо-камеры», где мы видим только информацию, подтверждающую наши собственные убеждения.

Влияние на Группы Риска

Алгоритмическая предвзятость оказывает особенно сильное влияние на группы риска, то есть на людей, которые уже сталкиваются с дискриминацией и неравенством. Для этих групп предвзятые алгоритмы могут усугубить существующие проблемы и создать новые барьеры.

Например, предвзятый алгоритм оценки кредитоспособности может лишить людей из бедных районов доступа к кредитам, что затруднит им возможность начать бизнес, купить дом или получить образование. Или предвзятый алгоритм найма на работу может увековечить гендерное неравенство в определенных отраслях.

«Технологии, как и любая другая форма власти, могут быть использованы для укрепления или ослабления существующих социальных иерархий.» – Кэти О’Нил, автор книги «Оружие математического уничтожения»

Как Обнаружить и Смягчить Предвзятость

Обнаружение и смягчение алгоритмической предвзятости – сложная, но необходимая задача. Вот несколько шагов, которые мы можем предпринять:

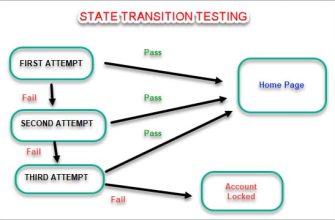

- Аудит алгоритмов: Регулярно проводить аудит алгоритмов, чтобы выявить и исправить предвзятости. Это может включать в себя анализ данных, используемых для обучения алгоритма, и оценку результатов для различных групп населения.

- Использование разнообразных данных: Стараться использовать данные, которые представляют все группы населения. Если данных недостаточно для определенных групп, необходимо собирать дополнительные данные.

- Разработка справедливых алгоритмов: Использовать методы, которые позволяют разрабатывать алгоритмы, минимизирующие предвзятость. Это может включать в себя использование алгоритмов, которые учитывают различные концепции справедливости.

- Прозрачность и подотчетность: Делать алгоритмы более прозрачными, чтобы люди могли понимать, как они работают и как принимают решения. Также необходимо установить механизмы подотчетности, чтобы люди могли обжаловать решения, принятые алгоритмами.

- Обучение и осведомленность: Повышать осведомленность о проблеме алгоритмической предвзятости среди разработчиков, политиков и широкой общественности.

Роль Регулирования

В некоторых случаях может потребоваться регулирование, чтобы предотвратить использование предвзятых алгоритмов. Например, Европейский союз разрабатывает законодательство об искусственном интеллекте, которое будет регулировать использование алгоритмов в определенных областях, таких как здравоохранение и образование.

Однако регулирование должно быть сбалансированным. Слишком жесткое регулирование может задушить инновации и замедлить развитие искусственного интеллекта. Важно найти золотую середину, которая защитит людей от вреда, причиненного предвзятыми алгоритмами, и позволит нам в полной мере воспользоваться преимуществами этой технологии.

Алгоритмическая предвзятость – серьезная проблема, которая требует нашего внимания. Мы должны осознавать, как алгоритмы влияют на нашу жизнь, и принимать меры для того, чтобы они использовались справедливо и беспристрастно. Работая вместе, мы можем создать мир, в котором алгоритмы будут служить нам, а не увековечивать неравенство.

Надеемся, эта статья помогла вам лучше понять проблему алгоритмической предвзятости и ее влияние на группы риска. Мы призываем вас продолжить изучение этой темы и активно участвовать в дискуссиях о том, как сделать алгоритмы более справедливыми.

Подробнее

| Запрос 1 | Запрос 2 | Запрос 3 | Запрос 4 | Запрос 5 |

|---|---|---|---|---|

| Влияние алгоритмов на общество | Предвзятость машинного обучения | Распознавание лиц и предвзятость | Справедливость в алгоритмах | Алгоритмы кредитного скоринга |

| Запрос 6 | Запрос 7 | Запрос 8 | Запрос 9 | Запрос 10 |

| Этические вопросы ИИ | Алгоритмы найма и дискриминация | Аудит алгоритмов | Регулирование искусственного интеллекта | Предвзятость в социальных сетях |