- Предвзятые Алгоритмы: Как Социально-Экономическое Неравенство Проникает в Код

- Что такое предвзятость алгоритмов и откуда она берется?

- Социально-экономический фактор: корень проблемы

- Примеры предвзятых алгоритмов в действии

- Что мы можем сделать, чтобы бороться с предвзятостью алгоритмов?

- Будущее алгоритмов: надежда на перемены

- Практические шаги для пользователей

Предвзятые Алгоритмы: Как Социально-Экономическое Неравенство Проникает в Код

Добро пожаловать в мир, где алгоритмы правят бал. Они определяют, какую рекламу мы видим, какие новости читаем, и даже – страшно сказать – какие шансы у нас получить работу или кредит. Но что, если эти всемогущие программы не так уж и беспристрастны, как нам кажется? Что, если в их коде затаились предрассудки, отражающие глубоко укоренившиеся социально-экономические проблемы?

Мы, как активные пользователи и наблюдатели за развитием технологий, все чаще сталкиваемся с ситуациями, когда алгоритмы принимают решения, кажущиеся несправедливыми или даже дискриминационными. И это не просто случайные ошибки. Зачастую это результат предвзятости, которая незаметно прокрадывается в процесс разработки и обучения этих сложных систем.

Что такое предвзятость алгоритмов и откуда она берется?

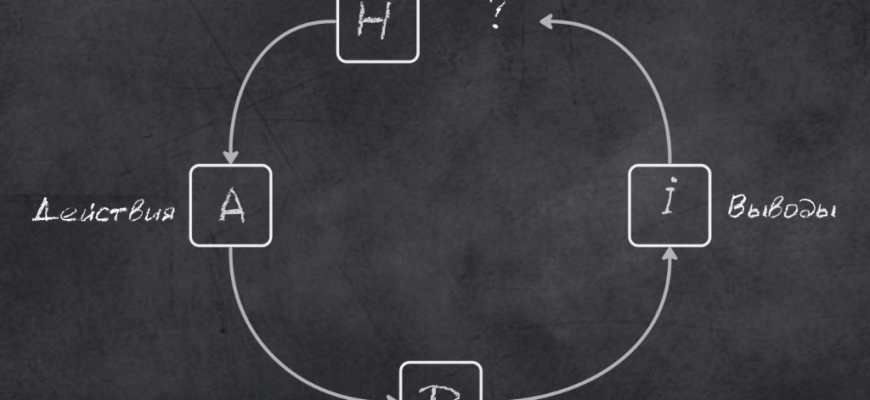

Предвзятость алгоритмов – это систематическая ошибка в выходных данных алгоритма, которая приводит к несправедливым или дискриминационным результатам. Источники этой предвзятости могут быть самыми разными:

- Предвзятые данные: Алгоритмы учатся на данных; Если данные отражают существующие социально-экономические неравенства, алгоритм усвоит эти предрассудки и будет воспроизводить их в своих решениях.

- Предвзятые разработчики: Люди, создающие алгоритмы, не свободны от собственных предубеждений. Эти предубеждения могут неосознанно проникать в код, влияя на то, как алгоритм обрабатывает и интерпретирует данные.

- Предвзятые метрики: Критерии, используемые для оценки эффективности алгоритма, могут быть предвзятыми. Например, если алгоритм, оценивающий кредитоспособность, исторически чаще отказывает в кредитах определенным группам населения, это может быть расценено как «успех», даже если это несправедливо.

Представьте себе алгоритм, который анализирует резюме и отбирает кандидатов на работу. Если в обучающих данных преобладают резюме мужчин, занимающих руководящие должности, алгоритм может начать отдавать предпочтение мужчинам, даже если женщины имеют не менее подходящие навыки и опыт. Это яркий пример того, как предвзятость данных может привести к дискриминации.

Социально-экономический фактор: корень проблемы

Социально-экономическое неравенство играет ключевую роль в формировании предвзятости алгоритмов. Вот как это происходит:

- Неравный доступ к ресурсам: Люди из разных социально-экономических слоев имеют разный доступ к образованию, здравоохранению и другим ресурсам. Это отражается в данных, которые используются для обучения алгоритмов.

- Историческая дискриминация: Многие алгоритмы обучаются на исторических данных, которые отражают прошлые случаи дискриминации. Например, алгоритм, предсказывающий вероятность совершения преступления, может быть предвзятым по отношению к определенным этническим группам, если в прошлом эти группы чаще подвергались арестам, даже если это было связано с предвзятостью правоохранительных органов.

- Цифровой разрыв: Не все люди имеют одинаковый доступ к интернету и цифровым технологиям. Это означает, что данные, собранные онлайн, могут быть нерепрезентативными для всего населения.

Например, алгоритм, определяющий, кому предоставлять государственную помощь, может быть предвзятым по отношению к людям, живущим в бедных районах, если в обучающих данных преобладают данные о людях, получающих помощь в этих районах. Это может привести к тому, что алгоритм будет отказывать в помощи людям, которые в ней нуждаются, просто потому, что они живут в «неправильном» месте.

Примеры предвзятых алгоритмов в действии

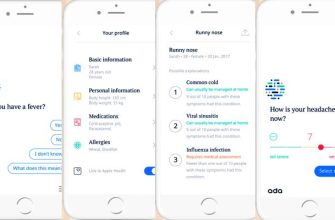

Вот несколько примеров того, как предвзятость алгоритмов проявляется в реальном мире:

- Системы оценки рисков в уголовном правосудии: Эти системы используются для оценки вероятности того, что подсудимый совершит новое преступление, если его отпустят под залог. Исследования показали, что эти системы часто предвзяты по отношению к афроамериканцам, которые чаще получают более высокие оценки риска, даже если они не представляют большей угрозы для общества.

- Алгоритмы найма: Как мы уже упоминали, алгоритмы, анализирующие резюме, могут быть предвзятыми по отношению к женщинам и представителям меньшинств.

- Алгоритмы кредитного скоринга: Эти алгоритмы могут быть предвзятыми по отношению к людям с низким уровнем дохода или к тем, кто живет в бедных районах.

- Системы распознавания лиц: Исследования показали, что эти системы часто менее точны при распознавании лиц темнокожих людей.

Эти примеры демонстрируют, что предвзятость алгоритмов – это не просто теоретическая проблема. Это реальная проблема, которая оказывает серьезное влияние на жизнь людей.

«Технологии – это не нейтральный инструмент. Они отражают ценности тех, кто их создает;»

— Джой Буоламвини, исследовательница в области искусственного интеллекта и активистка

Что мы можем сделать, чтобы бороться с предвзятостью алгоритмов?

Борьба с предвзятостью алгоритмов – это сложная задача, требующая усилий со стороны разработчиков, политиков и общественности. Вот несколько шагов, которые мы можем предпринять:

- Собирать и использовать более репрезентативные данные: Важно, чтобы данные, используемые для обучения алгоритмов, отражали разнообразие населения;

- Обеспечивать прозрачность алгоритмов: Мы должны понимать, как работают алгоритмы и какие факторы влияют на их решения.

- Проводить аудит алгоритмов: Независимые эксперты должны регулярно проверять алгоритмы на предмет предвзятости.

- Разрабатывать более справедливые метрики: Мы должны использовать критерии, которые не увековечивают существующие социально-экономические неравенства.

- Обучать разработчиков: Разработчики должны быть осведомлены о проблеме предвзятости алгоритмов и обучены тому, как ее избегать.

- Привлекать к разработке алгоритмов людей из разных слоев общества: Разнообразие в командах разработчиков может помочь выявить и устранить предвзятость.

Мы должны помнить, что алгоритмы – это всего лишь инструменты. Они могут быть использованы для создания более справедливого мира, но только если мы будем внимательны к тому, как они разрабатываются и используются.

Будущее алгоритмов: надежда на перемены

Несмотря на существующие проблемы, мы видим признаки того, что ситуация начинает меняться. Растет осознание проблемы предвзятости алгоритмов, и все больше людей и организаций работают над ее решением. Появляются новые инструменты и методы для выявления и устранения предвзятости, и все больше разработчиков осознают свою ответственность за создание справедливых и беспристрастных алгоритмов.

Мы верим, что в будущем алгоритмы смогут стать мощным инструментом для решения социальных проблем и создания более справедливого и равноправного мира. Но для этого нам необходимо продолжать работать над тем, чтобы они были свободны от предрассудков и отражали лучшие ценности нашего общества.

Практические шаги для пользователей

Что можем сделать мы, как обычные пользователи, чтобы внести свой вклад в борьбу с предвзятостью алгоритмов?

- Задавайте вопросы: Не бойтесь спрашивать, как работают алгоритмы, которые влияют на вашу жизнь.

- Сообщайте о случаях предвзятости: Если вы столкнулись с алгоритмом, который кажется вам предвзятым, сообщите об этом разработчикам или в соответствующие органы.

- Поддерживайте организации, борющиеся с предвзятостью алгоритмов: Есть много организаций, которые работают над тем, чтобы алгоритмы были более справедливыми и беспристрастными. Вы можете поддержать их финансово или своим временем.

- Распространяйте информацию: Поделитесь этой статьей с друзьями и коллегами, чтобы повысить осведомленность о проблеме предвзятости алгоритмов.

Вместе мы можем сделать так, чтобы алгоритмы работали на благо всех нас, а не только избранных.

Подробнее

| Предвзятость ИИ | Алгоритмическая дискриминация | Социально-экономическое неравенство и алгоритмы | Справедливость алгоритмов | Этика искусственного интеллекта |

|---|---|---|---|---|

| Влияние алгоритмов на общество | Прозрачность алгоритмов | Аудит алгоритмов | Репрезентативные данные для ИИ | Борьба с дискриминацией в ИИ |