Предвзятые алгоритмы: Как гендерные стереотипы проникают в код и влияют на нашу жизнь

Мы живем в эпоху алгоритмов. Они решают, какую рекламу мы видим, какие новости читаем, и даже, получим ли мы кредит или работу. Но что, если эти алгоритмы не такие уж и беспристрастные, как нам кажется? Что, если в их код заложены неосознанные (или даже осознанные) предубеждения, которые влияют на жизнь миллионов людей? Сегодня мы поговорим об одной из самых острых проблем в этой области – гендерной предвзятости алгоритмов.

Эта проблема касается каждого из нас, вне зависимости от пола. Ведь алгоритмы, пропитанные гендерными стереотипами, могут ограничивать возможности, создавать несправедливость и увековечивать устаревшие представления о роли мужчин и женщин в обществе. Мы рассмотрим, как это происходит, какие последствия это влечет за собой, и что мы можем сделать, чтобы изменить ситуацию.

Что такое предвзятость алгоритмов?

Предвзятость алгоритмов – это систематические ошибки в алгоритмических решениях, которые приводят к несправедливым или дискриминационным результатам. Эти ошибки могут возникать из-за различных факторов, включая:

- Предвзятые данные: Алгоритмы обучаются на данных. Если данные отражают исторические или существующие предубеждения, алгоритм неизбежно их усвоит и воспроизведет.

- Предвзятые цели: Цель, которую ставит перед собой разработчик алгоритма, может быть сформулирована таким образом, что она неосознанно увековечивает существующие стереотипы.

- Предвзятые методы: Выбор определенных алгоритмических методов или параметров может привести к дискриминационным результатам.

- Предвзятые интерпретации: Даже если алгоритм сам по себе не содержит предвзятости, его результаты могут быть неправильно интерпретированы, что приведет к несправедливым решениям.

Важно понимать, что предвзятость алгоритмов не всегда является результатом злого умысла. Часто это происходит неосознанно, из-за недостатка внимания к деталям или из-за отсутствия разнообразия в командах разработчиков.

Как гендерные стереотипы проникают в алгоритмы?

Гендерные стереотипы – это широко распространенные представления о том, какие качества, характеристики и роли присущи мужчинам и женщинам. Они глубоко укоренены в нашей культуре и обществе, и, к сожалению, они также проникают в алгоритмы.

Вот несколько конкретных примеров:

- Рекрутинговые алгоритмы: Если исторически в определенной отрасли преобладали мужчины, рекрутинговый алгоритм, обученный на данных о прошлых успешных кандидатах, может отдавать предпочтение мужчинам, даже если женщины не менее квалифицированы.

- Алгоритмы распознавания лиц: Исследования показали, что алгоритмы распознавания лиц часто менее точны в отношении женщин и людей с темным цветом кожи. Это может приводить к проблемам с безопасностью и идентификацией.

- Алгоритмы кредитного скоринга: Если алгоритм использует данные о прошлых кредитных историях, он может дискриминировать женщин, если исторически они имели меньше возможностей для получения кредитов или сталкивались с более высокими процентными ставками.

- Виртуальные ассистенты: Многие виртуальные ассистенты, такие как Siri и Alexa, изначально имели женские голоса и были запрограммированы на выполнение преимущественно секретарских функций. Это закрепляет стереотип о том, что женщины должны быть помощницами и обслуживать мужчин.

Проблема усугубляется тем, что многие алгоритмы являются «черными ящиками». Мы не знаем, как они работают и какие факторы учитывают при принятии решений. Это затрудняет выявление и исправление предвзятости.

Технологии – это зеркало, которое отражает наши собственные предубеждения и предрассудки.

Последствия гендерной предвзятости алгоритмов

Последствия гендерной предвзятости алгоритмов могут быть весьма серьезными и далеко идущими:

- Ограничение возможностей: Женщинам может быть сложнее получить работу, кредит, образование или другие ресурсы, если алгоритмы систематически отдают предпочтение мужчинам.

- Увековечение стереотипов: Алгоритмы, пропитанные гендерными стереотипами, могут закреплять и усиливать эти стереотипы в обществе.

- Экономические потери: Недооценка потенциала женщин может приводить к экономическим потерям для отдельных компаний и для общества в целом.

- Социальная несправедливость: Гендерная предвзятость алгоритмов может усугублять существующее неравенство и создавать новые формы дискриминации.

Например, представьте себе женщину, которая подает заявку на работу в сфере технологий. Она обладает всеми необходимыми навыками и опытом, но рекрутинговый алгоритм, обученный на данных о прошлых успешных кандидатах (в основном мужчинах), автоматически отклоняет ее заявку. В результате она теряет возможность реализовать свой потенциал, а компания упускает талантливого сотрудника.

Что мы можем сделать?

Борьба с гендерной предвзятостью алгоритмов – это сложная, но важная задача, которая требует совместных усилий со стороны разработчиков, компаний, правительств и общества в целом. Вот несколько шагов, которые мы можем предпринять:

- Повышение осведомленности: Важно понимать, что гендерная предвзятость алгоритмов – это реальная проблема, которая требует внимания. Чем больше людей об этом знают, тем больше шансов, что мы сможем изменить ситуацию.

- Диверсификация команд разработчиков: Команды разработчиков должны быть более разнообразными, чтобы включать в себя людей разного пола, расы, этнической принадлежности и социально-экономического происхождения. Это поможет выявлять и устранять предвзятость на ранних стадиях разработки.

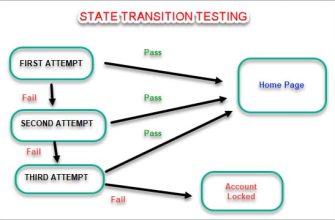

- Аудит алгоритмов: Алгоритмы должны регулярно проверяться на наличие предвзятости. Существуют различные инструменты и методы, которые могут помочь в этом.

- Использование беспристрастных данных: Алгоритмы должны обучаться на данных, которые не содержат гендерных стереотипов. Если это невозможно, необходимо использовать методы, которые позволяют смягчить влияние предвзятых данных.

- Прозрачность и подотчетность: Алгоритмы должны быть более прозрачными, чтобы мы могли понимать, как они работают и какие факторы учитывают при принятии решений. Компании должны нести ответственность за предвзятые алгоритмы и принимать меры по их исправлению.

- Регулирование: Правительства должны разработать и внедрить правила, которые запрещают дискриминацию на основе алгоритмов.

Мы, как пользователи, также можем внести свой вклад. Мы можем задавать вопросы, требовать прозрачности и поддерживать компании, которые борются с гендерной предвзятостью алгоритмов.

Гендерная предвзятость алгоритмов – это серьезная проблема, которая требует немедленного внимания. Мы должны осознать, что алгоритмы не являются нейтральными и что они могут увековечивать и усиливать существующие стереотипы. Но у нас есть возможность изменить ситуацию. Вместе мы можем создать более справедливое и равноправное будущее, в котором алгоритмы будут служить интересам всех людей, независимо от их пола.

Подробнее

| Гендерная предвзятость в AI | Алгоритмическая дискриминация | Справедливость в машинном обучении | Этика искусственного интеллекта | Предвзятость данных в AI |

|---|---|---|---|---|

| Рекрутинговые алгоритмы и гендер | Распознавание лиц и предвзятость | Кредитный скоринг и женщины | Виртуальные ассистенты и стереотипы | Борьба с предвзятостью алгоритмов |