- Разбираем «Черный Ящик»: Как Понять и Контролировать Глубокое Обучение

- Что Такое «Черный Ящик» в Контексте Глубокого Обучения?

- Основные Проблемы «Черного Ящика»

- Отсутствие Интерпретируемости

- Сложность Отладки и Тестирования

- Потенциальная Предвзятость и Дискриминация

- Уязвимость к Атакам

- Как Бороться с «Черным Ящиком»?

- Использование Интерпретируемых Моделей

- Методы Объяснимого ИИ (XAI)

- Визуализация и Мониторинг

- Использование Разнообразных Данных и Аугментация Данных

- Прозрачность в Процессе Разработки

Разбираем «Черный Ящик»: Как Понять и Контролировать Глубокое Обучение

В мире искусственного интеллекта, глубокое обучение (Deep Learning) занимает особое место․ Его алгоритмы лежат в основе многих современных технологий, от распознавания лиц до автоматического перевода․ Но часто, когда мы сталкиваемся с этими сложными системами, возникает ощущение, что заглядываем в «черный ящик»․ Мы видим входные данные и выходные результаты, но то, что происходит внутри, остается загадкой․ Давайте разберемся, почему это так, и что мы можем с этим сделать․

Мы, как пользователи и разработчики, все чаще полагаемся на решения, принимаемые сложными алгоритмами․ Но как нам доверять этим решениям, если мы не понимаем, как они к ним пришли? Эта непрозрачность порождает множество проблем, от этических до практических․ В этой статье мы поделимся нашим опытом и разберем основные проблемы «черного ящика» в глубоком обучении, а также предложим некоторые решения и подходы, которые помогут нам лучше понимать и контролировать эти мощные инструменты․

Что Такое «Черный Ящик» в Контексте Глубокого Обучения?

Когда мы говорим о «черном ящике», мы имеем в виду систему, внутренние механизмы работы которой нам неизвестны или труднодоступны для понимания․ В контексте глубокого обучения, это относится к сложным нейронным сетям, которые содержат множество слоев и параметров․ Эти сети способны решать сложные задачи, но процесс принятия решений внутри них часто остается непрозрачным․

Представьте себе, что вы обучаете нейронную сеть распознавать кошек на фотографиях․ После обучения сеть успешно справляется с этой задачей, но как именно она это делает? Какие признаки она использует для идентификации кошек? Почему она иногда ошибается? Ответы на эти вопросы не всегда очевидны, и именно эта неопределенность делает глубокое обучение похожим на «черный ящик»․

Основные Проблемы «Черного Ящика»

Отсутствие Интерпретируемости

Это, пожалуй, самая главная проблема․ Мы не можем легко понять, почему нейронная сеть приняла то или иное решение․ Это затрудняет отладку, проверку на предвзятость и объяснение результатов․ Когда дело касается критически важных приложений, таких как медицина или финансы, отсутствие интерпретируемости может иметь серьезные последствия․

Например, представьте, что алгоритм ставит диагноз пациенту, но врач не может понять, на основании каких данных был сделан этот вывод․ Врач не может доверять этому диагнозу, не понимая его обоснования․ Это создает серьезные проблемы для принятия решений в области здравоохранения․

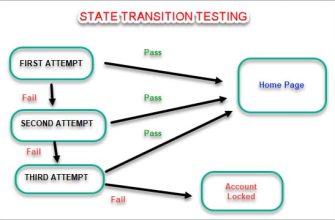

Сложность Отладки и Тестирования

Из-за непрозрачности внутренних механизмов нейронных сетей, отладка и тестирование становятся сложной задачей․ Если алгоритм выдает неправильный результат, трудно понять, где именно произошла ошибка и как ее исправить․ Традиционные методы отладки, такие как пошаговое выполнение кода, здесь не работают․

Нам приходится полагаться на косвенные методы, такие как анализ входных данных и выходных результатов, а также на различные техники визуализации․ Однако эти методы не всегда позволяют выявить все проблемы и могут быть трудоемкими в применении․

Потенциальная Предвзятость и Дискриминация

Нейронные сети обучаются на данных, и если эти данные содержат предвзятости, то сеть может усвоить эти предвзятости и воспроизводить их в своих решениях․ Это может привести к дискриминации по расовому, половому или иным признакам․

Например, если алгоритм, используемый для отбора кандидатов на работу, обучался на данных, в которых преобладали мужчины, то он может отдавать предпочтение мужчинам, даже если женщины имеют такую же квалификацию․ Выявление и устранение таких предвзятостей является сложной задачей, требующей особого внимания․

Уязвимость к Атакам

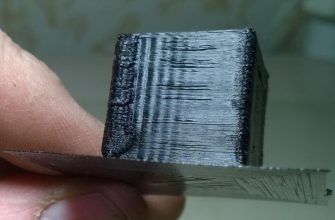

Глубокие нейронные сети могут быть уязвимы к так называемым «состязательным атакам» (adversarial attacks)․ Это специально разработанные входные данные, которые незначительно отличаются от обычных, но могут заставить сеть принять неправильное решение․ Эти атаки могут иметь серьезные последствия, особенно в системах безопасности и автономного вождения․

Представьте, что злоумышленник изменяет дорожный знак так, что автономный автомобиль не может его распознать и совершает аварию․ Защита от таких атак требует разработки специальных методов и подходов․

«Недостаточно просто создавать искусственный интеллект, мы должны создавать искусственный интеллект, который можно понять․» ⸺ Джилл Уотсон, IBM

Как Бороться с «Черным Ящиком»?

Хотя полностью избавиться от «черного ящика» в глубоком обучении, вероятно, невозможно, мы можем предпринять шаги, чтобы сделать эти системы более прозрачными и понятными․

Использование Интерпретируемых Моделей

Вместо того, чтобы всегда использовать самые сложные и непрозрачные модели, мы можем выбирать более простые и интерпретируемые модели, когда это возможно․ Например, линейные модели или деревья решений часто легче понять, чем глубокие нейронные сети․

Иногда небольшая потеря в точности может быть оправдана, если мы получаем взамен более понятную и контролируемую систему․ Важно взвешивать преимущества и недостатки различных моделей и выбирать ту, которая лучше всего подходит для конкретной задачи․

Методы Объяснимого ИИ (XAI)

Объяснимый ИИ (Explainable AI, XAI) – это область исследований, направленная на разработку методов, которые позволяют понимать и объяснять решения, принимаемые сложными алгоритмами․ Существует множество различных методов XAI, которые можно использовать для анализа нейронных сетей․

- LIME (Local Interpretable Model-agnostic Explanations): Этот метод позволяет объяснить отдельные прогнозы модели, путем аппроксимации локальной области вокруг прогноза более простой, интерпретируемой моделью․

- SHAP (SHapley Additive exPlanations): Этот метод использует теорию игр для оценки вклада каждого признака в прогноз модели․

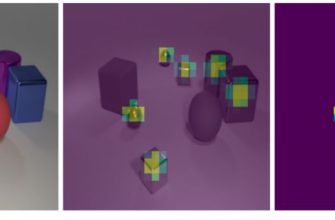

- Grad-CAM (Gradient-weighted Class Activation Mapping): Этот метод позволяет визуализировать, какие части входного изображения наиболее важны для принятия решения нейронной сетью․

Визуализация и Мониторинг

Визуализация внутренних состояний нейронной сети может помочь нам понять, как она работает․ Например, мы можем визуализировать активации различных слоев сети, чтобы увидеть, какие признаки она обнаруживает․

Мониторинг работы сети в реальном времени также может помочь нам выявить проблемы и аномалии․ Мы можем отслеживать такие показатели, как точность, потери и уверенность в прогнозах, чтобы убедиться, что сеть работает должным образом․

Использование Разнообразных Данных и Аугментация Данных

Обучение нейронной сети на разнообразных данных может помочь уменьшить предвзятость и повысить ее обобщающую способность․ Аугментация данных, то есть создание новых обучающих примеров путем модификации существующих, также может быть полезной․

Например, при обучении сети распознаванию изображений, мы можем поворачивать, масштабировать и обрезать изображения, чтобы создать новые обучающие примеры․ Это поможет сети лучше справляться с различными условиями и уменьшить зависимость от конкретных особенностей обучающих данных;

Прозрачность в Процессе Разработки

Прозрачность должна быть заложена в процесс разработки с самого начала․ Мы должны документировать все этапы разработки, включая выбор данных, архитектуру модели, параметры обучения и методы оценки․ Это позволит другим разработчикам и исследователям понимать и воспроизводить наши результаты, а также выявлять потенциальные проблемы․

Кроме того, мы должны быть открыты к обратной связи и критике со стороны сообщества․ Обмен знаниями и опытом поможет нам вместе решать проблемы «черного ящика» и создавать более надежные и этичные системы искусственного интеллекта․

Проблема «черного ящика» в глубоком обучении – это сложная и многогранная задача, которая требует комплексного подхода․ Мы должны использовать различные методы и подходы, чтобы сделать эти системы более прозрачными, понятными и контролируемыми․ Это позволит нам доверять им, использовать их эффективно и избегать потенциальных негативных последствий․ Работа в этом направлении – это не просто техническая задача, но и этическая ответственность перед обществом․

Мы надеемся, что наш опыт и советы, изложенные в этой статье, помогут вам лучше понимать и контролировать глубокое обучение․ Помните, что ключ к успеху – это постоянное обучение, эксперименты и стремление к прозрачности․ Вместе мы можем сделать искусственный интеллект более надежным и полезным для всех․

Подробнее

| Интерпретируемость Deep Learning | Объяснимый Искусственный Интеллект | Отладка нейронных сетей | Предвзятость в AI | Состязательные атаки |

|---|---|---|---|---|

| Визуализация нейронных сетей | Мониторинг AI | Аугментация данных | Прозрачность AI | XAI методы |