- Расшифровка «Черного Ящика»: Как Создать Прозрачные и Понятные Модели

- Что такое «Черный Ящик» и Почему Это Проблема?

- Методы Создания Прозрачных Моделей

- Использование Интерпретируемых Моделей

- Feature Importance и Permutation Importance

- LIME (Local Interpretable Model-agnostic Explanations)

- SHAP (SHapley Additive exPlanations)

- Визуализация

- Практический Пример: Прогнозирование Оттока Клиентов

- Преимущества Прозрачных Моделей

Расшифровка «Черного Ящика»: Как Создать Прозрачные и Понятные Модели

В мире, где алгоритмы принимают все больше решений, от финансовых до медицинских, становится критически важным понимать, как именно эти алгоритмы работают. Нас, как блогеров, всегда интересовала тема искусственного интеллекта, и особенно его применение в реальной жизни. Однако, часто мы сталкиваемся с так называемыми «черными ящиками» – моделями, которые выдают результаты, но объяснить логику их работы практически невозможно. Это создает проблемы с доверием, ответственностью и, в конечном счете, с эффективностью использования этих моделей.

Мы решили разобраться в этой проблеме и поделиться нашим опытом создания прозрачных моделей, которые можно не только использовать, но и понимать. Мы расскажем о методах, которые помогут вам «открыть» черный ящик и сделать его работу более понятной для себя и для других.

Что такое «Черный Ящик» и Почему Это Проблема?

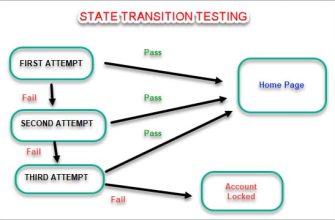

Представьте себе сложную систему, которая принимает на вход данные и выдает результат. Вы видите вход и выход, но совершенно не понимаете, что происходит внутри. Это и есть «черный ящик». В контексте машинного обучения, это часто относится к сложным моделям, таким как глубокие нейронные сети, которые имеют миллионы параметров и сложные взаимосвязи.

Проблемы с «черными ящиками» многочисленны:

- Отсутствие доверия: Если мы не понимаем, как модель пришла к определенному решению, нам сложно доверять этому решению.

- Проблемы с отладкой: Если модель выдает неправильный результат, сложно понять, где именно произошла ошибка и как ее исправить.

- Этические вопросы: «Черные ящики» могут принимать решения, которые дискриминируют определенные группы людей, и мы можем даже не знать об этом.

- Регуляторные требования: В некоторых отраслях, например, в финансах, регулирующие органы требуют объяснения принимаемых решений.

Методы Создания Прозрачных Моделей

К счастью, существуют методы, которые позволяют нам сделать модели более прозрачными. Мы испробовали множество подходов и хотим поделиться наиболее эффективными:

Использование Интерпретируемых Моделей

Самый простой способ избежать проблемы «черного ящика» – это использовать модели, которые по своей природе легко интерпретируются. К таким моделям относятся:

- Линейная регрессия: В линейной регрессии мы можем легко увидеть, как каждый признак влияет на результат.

- Логистическая регрессия: Аналогично линейной регрессии, логистическая регрессия позволяет нам понять вклад каждого признака в вероятность определенного исхода.

- Деревья решений: Деревья решений представляют собой иерархическую структуру правил, которые легко визуализировать и понять.

Пример: Предположим, мы хотим предсказать, одобрит ли банк заявку на кредит. Используя логистическую регрессию, мы можем определить, какие факторы, такие как кредитная история, доход и возраст, наиболее сильно влияют на решение банка.

Feature Importance и Permutation Importance

Даже если мы используем более сложную модель, мы можем оценить важность каждого признака. Feature Importance показывает, насколько каждый признак влияет на предсказания модели. Permutation Importance – это метод, который оценивает важность признака путем случайного перемешивания значений этого признака и оценки того, насколько ухудшается производительность модели. Чем сильнее ухудшается производительность, тем важнее признак.

Мы часто используем библиотеку scikit-learn в Python для вычисления Feature Importance. Это позволяет нам понять, какие факторы являются ключевыми для модели и на чем стоит сосредоточиться.

LIME (Local Interpretable Model-agnostic Explanations)

LIME – это метод, который позволяет объяснить предсказания любой модели, аппроксимируя ее локально линейной моделью. Другими словами, для каждого конкретного предсказания LIME создает упрощенную, интерпретируемую модель, которая объясняет, почему модель пришла к этому предсказанию.

Как это работает: LIME создает небольшую выборку данных вокруг интересующей нас точки. Затем он обучает линейную модель на этой выборке, используя исходную модель для получения предсказаний. В результате мы получаем линейную модель, которая объясняет предсказание исходной модели в окрестности интересующей нас точки.

SHAP (SHapley Additive exPlanations)

SHAP – это еще один мощный метод, который объясняет предсказания модели на основе теории игр. Он вычисляет вклад каждого признака в предсказание, используя значения Шепли. Значения Шепли гарантируют, что объяснения будут справедливыми и согласованными.

Преимущества SHAP:

- Теоретически обоснован: SHAP основан на теории игр, что обеспечивает математическую строгость и надежность.

- Глобальная и локальная интерпретируемость: SHAP может использоваться для объяснения как отдельных предсказаний, так и общей работы модели.

- Интерактивность: SHAP предоставляет инструменты для визуализации и анализа объяснений, что позволяет пользователям глубже понять работу модели.

«Недостаточно просто знать, что что-то работает. Важно понимать, почему это работает.» ⏤ Ричард Фейнман

Визуализация

Визуализация данных и работы модели – это мощный инструмент для понимания. Мы используем различные графики и диаграммы, чтобы увидеть, как модель принимает решения. Например, мы можем визуализировать деревья решений, графики Feature Importance, или графики зависимости между признаками и предсказаниями.

Примеры визуализаций:

- Графики рассеяния: Показывают взаимосвязь между двумя признаками.

- Гистограммы: Показывают распределение значений признака.

- Тепловые карты: Показывают корреляцию между признаками.

- Деревья решений: Визуальное представление правил, используемых моделью.

Практический Пример: Прогнозирование Оттока Клиентов

Давайте рассмотрим пример прогнозирования оттока клиентов (churn prediction) в телекоммуникационной компании. У нас есть данные о клиентах, включающие информацию о их тарифных планах, использовании услуг, платежах и демографических характеристиках. Мы хотим построить модель, которая предсказывает, какие клиенты с наибольшей вероятностью уйдут.

Шаги, которые мы предприняли:

- Выбор модели: Начнем с логистической регрессии, так как она легко интерпретируется.

- Оценка Feature Importance: Определим, какие признаки наиболее сильно влияют на отток клиентов.

- Использование LIME и SHAP: Объясним предсказания модели для конкретных клиентов.

- Визуализация: Создадим графики, показывающие взаимосвязь между признаками и оттоком клиентов.

Результаты: Мы обнаружили, что наиболее важными факторами, влияющими на отток клиентов, являются: длительность использования услуг, количество звонков в службу поддержки и наличие конкурентного предложения. Используя LIME и SHAP, мы смогли объяснить, почему модель предсказала отток для конкретных клиентов, например, из-за высокой стоимости услуг и плохого обслуживания.

Преимущества Прозрачных Моделей

Создание прозрачных моделей имеет множество преимуществ:

- Повышение доверия: Когда мы понимаем, как работает модель, мы больше доверяем ее решениям.

- Улучшение отладки: Легче выявить и исправить ошибки в модели.

- Снижение риска дискриминации: Мы можем проверить, не принимает ли модель решения, которые дискриминируют определенные группы людей.

- Соответствие регуляторным требованиям: Мы можем предоставить объяснения принимаемых решений регулирующим органам.

Проблема «черного ящика» в машинном обучении – это серьезная проблема, но она решаема. Используя методы, которые мы описали, мы можем создавать прозрачные модели, которые можно не только использовать, но и понимать. Это позволит нам повысить доверие к алгоритмам, улучшить их отладку, снизить риск дискриминации и соответствовать регуляторным требованиям. Мы надеемся, что наш опыт поможет вам в создании более прозрачных и понятных моделей.

Подробнее

| Интерпретируемость моделей машинного обучения | Объяснимый искусственный интеллект (XAI) | Методы анализа Feature Importance | Визуализация моделей машинного обучения | Примеры прозрачных моделей |

|---|---|---|---|---|

| LIME для объяснения предсказаний | SHAP значения и их интерпретация | Прозрачность нейронных сетей | Проблемы доверия к AI | Отладка моделей машинного обучения |