- Проблемы с “черным ящиком”: Как завоевать доверие врачей к AI в медицине

- Что такое «черный ящик» в контексте AI?

- Почему «черный ящик» – это проблема для медицины?

- Пути решения проблемы «черного ящика»

- Разрабатывайте интерпретируемые модели

- Используйте методы объяснимого AI (XAI)

- Визуализируйте процесс принятия решений

- Обучайте врачей работать с AI

- Создавайте «AI-ассистентов», а не «AI-заменителей»

- Примеры успешного внедрения AI в медицине

- Будущее AI в медицине: доверие и прозрачность

Проблемы с “черным ящиком”: Как завоевать доверие врачей к AI в медицине

Искусственный интеллект (AI) все глубже проникает в нашу жизнь, и медицина не исключение. Мы видим, как AI помогает в диагностике, лечении и даже в разработке новых лекарств. Однако, несмотря на огромный потенциал, существует серьезное препятствие на пути к широкому внедрению AI в медицине – проблема «черного ящика». Врачи, как и любые профессионалы, принимающие важные решения, должны понимать, как AI приходит к своим выводам, чтобы доверять ему и эффективно использовать его в своей практике. Именно об этом мы и поговорим сегодня: о вызовах, возможностях и, конечно, о том, как преодолеть этот барьер доверия.

Представьте себе ситуацию: AI предлагает план лечения для пациента с редким заболеванием. Врач видит этот план, но не понимает, почему именно такие препараты и в такой дозировке были выбраны. Что он должен сделать? Просто довериться алгоритму? Или потратить часы на самостоятельное исследование, чтобы проверить предложенное решение? В большинстве случаев, врач, вероятно, выберет второй вариант, а это означает, что AI не сможет полностью раскрыть свой потенциал и сэкономить ценное время специалиста.

Что такое «черный ящик» в контексте AI?

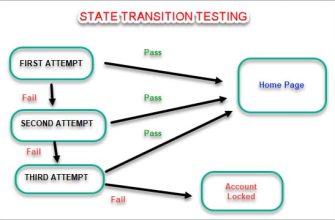

Термин «черный ящик» относится к системам, чьи внутренние процессы непрозрачны и труднообъяснимы. В контексте AI это означает, что мы можем видеть входные данные (например, результаты анализов пациента) и выходные данные (например, диагноз или план лечения), но не понимать, как именно AI пришел к этому выводу. Это особенно актуально для сложных моделей машинного обучения, таких как глубокие нейронные сети, которые могут содержать миллионы или даже миллиарды параметров.

Причина, по которой AI часто называют «черным ящиком», кроется в сложности алгоритмов. Эти алгоритмы настолько сложны, что даже разработчики не всегда могут точно объяснить, почему они принимают те или иные решения. Более того, AI часто обучается на огромных объемах данных, и в процессе обучения он может выявлять закономерности, которые не очевидны для человека. Это может приводить к тому, что AI будет предлагать эффективные решения, но при этом оставаться загадкой для врачей.

Почему «черный ящик» – это проблема для медицины?

Доверие является краеугольным камнем в отношениях между врачом и пациентом. Врач должен не только знать, что делать, но и уметь объяснить пациенту, почему он это делает. Когда дело касается AI, эта необходимость в объяснении становится еще более важной. Если врач не понимает, как AI пришел к своему выводу, он не сможет убедительно объяснить это пациенту, что может подорвать доверие к лечению.

- Ответственность: Врач несет юридическую и этическую ответственность за принятые решения. Невозможно переложить эту ответственность на AI, особенно если не понимаешь, как он работает.

- Прозрачность: В медицине важна прозрачность. Врач должен иметь возможность объяснить свои действия коллегам, пациентам и регулирующим органам.

- Безопасность: Если врач не понимает, как AI принимает решения, он не может адекватно оценить риски и предотвратить ошибки.

- Обучение: Врачи учатся на своих ошибках и на опыте коллег. Если AI работает как «черный ящик», его нельзя использовать для обучения и совершенствования медицинской практики.

Пути решения проблемы «черного ящика»

К счастью, проблема «черного ящика» не является неразрешимой. Существует несколько подходов, которые позволяют сделать AI более прозрачным и понятным для врачей.

Разрабатывайте интерпретируемые модели

Вместо того, чтобы использовать сложные нейронные сети, можно разрабатывать модели, которые изначально более интерпретируемы. Например, можно использовать линейные модели, деревья решений или правила, которые легко понять и объяснить. Конечно, такие модели могут быть менее точными, чем сложные нейронные сети, но в некоторых случаях интерпретируемость важнее точности.

Используйте методы объяснимого AI (XAI)

XAI – это область исследований, которая занимается разработкой методов, позволяющих объяснять решения, принимаемые AI. Существует множество различных методов XAI, каждый из которых имеет свои преимущества и недостатки. Некоторые из наиболее распространенных методов включают:

- LIME (Local Interpretable Model-agnostic Explanations): Этот метод позволяет объяснить решение AI для конкретного случая, путем построения локальной линейной модели, которая аппроксимирует поведение AI в окрестности этого случая.

- SHAP (SHapley Additive exPlanations): Этот метод использует теорию игр для определения вклада каждого признака в решение AI.

- Feature Importance: Этот метод позволяет определить, какие признаки наиболее важны для принятия решений AI.

Визуализируйте процесс принятия решений

Визуализация может помочь врачам понять, как AI принимает решения. Например, можно визуализировать, какие области на медицинском изображении (например, рентгеновском снимке) привлекли внимание AI при постановке диагноза. Это может помочь врачу понять, почему AI пришел к такому выводу, и убедиться, что он не допустил ошибку.

Обучайте врачей работать с AI

Врачи должны быть обучены тому, как интерпретировать результаты, полученные с помощью AI, и как использовать AI в своей практике. Это включает в себя понимание ограничений AI, умение оценивать риски и преимущества, а также умение интегрировать AI в существующие рабочие процессы.

«Искусственный интеллект не заменит врачей, но врачи, использующие искусственный интеллект, заменят тех, кто его не использует.» — Д-р Эрик Тополь

Создавайте «AI-ассистентов», а не «AI-заменителей»

Важно подчеркнуть, что AI не должен рассматриваться как замена врачам. AI должен быть инструментом, который помогает врачам принимать более обоснованные решения и экономить время. AI может автоматизировать рутинные задачи, анализировать большие объемы данных и предоставлять врачам ценную информацию, но окончательное решение всегда должно оставаться за врачом.

Примеры успешного внедрения AI в медицине

Несмотря на проблемы с «черным ящиком», существует множество примеров успешного внедрения AI в медицине. Например:

- Диагностика рака: AI может анализировать медицинские изображения (например, маммограммы, КТ-снимки) для выявления признаков рака на ранних стадиях.

- Разработка лекарств: AI может анализировать большие объемы данных для выявления потенциальных лекарственных средств и предсказания их эффективности.

- Персонализированная медицина: AI может анализировать генетические данные пациента для разработки индивидуальных планов лечения.

- Управление здравоохранением: AI может прогнозировать распространение заболеваний, оптимизировать распределение ресурсов и улучшать качество обслуживания пациентов.

Эти примеры показывают, что AI может принести огромную пользу медицине, но только если он используется правильно и с учетом этических и практических соображений.

Будущее AI в медицине: доверие и прозрачность

Будущее AI в медицине зависит от нашей способности решать проблему «черного ящика» и завоевывать доверие врачей. Это требует совместных усилий разработчиков AI, врачей, исследователей и регулирующих органов. Мы должны разрабатывать более интерпретируемые модели, использовать методы XAI, обучать врачей и создавать «AI-ассистентов», которые помогают, а не заменяют врачей.

Только тогда мы сможем полностью раскрыть потенциал AI в медицине и сделать ее более эффективной, безопасной и персонализированной.

Подробнее

| AI в здравоохранении | Машинное обучение в медицине | Интерпретируемость AI | Объяснимый AI (XAI) | Доверие к AI в медицине |

|---|---|---|---|---|

| Этика AI в медицине | Риски AI в медицине | Применение AI в диагностике | Персонализированная медицина AI | Внедрение AI в клиническую практику |