- Раскрываем Тайны «Черного Ящика»: Методы Объяснимого Искусственного Интеллекта (XAI)

- Что такое «Черный Ящик» в контексте ИИ?

- Почему Объяснимость ИИ (XAI) так важна?

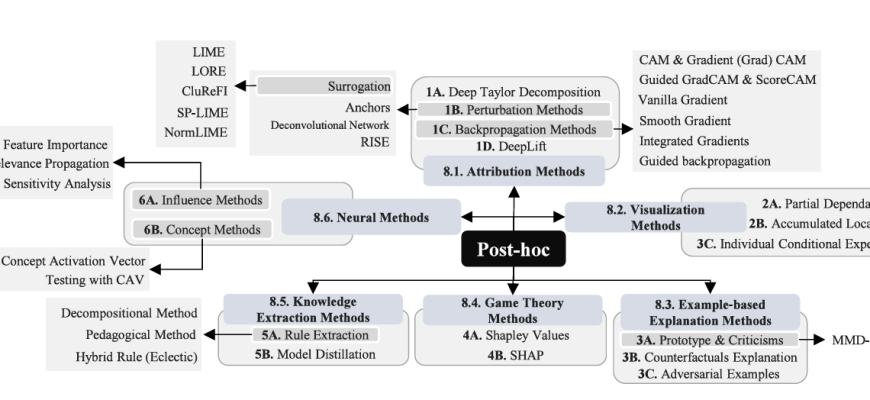

- Основные методы XAI, которые мы попробовали

- LIME (Local Interpretable Model-agnostic Explanations)

- SHAP (SHapley Additive exPlanations)

- Grad-CAM (Gradient-weighted Class Activation Mapping)

- Decision Trees

- Практические примеры применения XAI

- Сложности и ограничения XAI

- Будущее XAI

Раскрываем Тайны «Черного Ящика»: Методы Объяснимого Искусственного Интеллекта (XAI)

В современном мире искусственный интеллект (ИИ) проникает во все сферы нашей жизни․ Он помогает нам принимать решения в медицине, финансах, транспорте и многих других областях․ Однако, часто эти решения принимаются «черными ящиками» – сложными алгоритмами, чья логика работы непонятна даже их создателям․ Нам стало интересно, как можно заглянуть внутрь этих «черных ящиков» и понять, почему ИИ принимает те или иные решения․ В этой статье мы поделимся нашим опытом изучения методов объяснимости ИИ (XAI) и расскажем, как они помогают нам доверять ИИ и использовать его более эффективно․

Что такое «Черный Ящик» в контексте ИИ?

Представьте себе сложную нейронную сеть, состоящую из миллионов параметров; Она обучена на огромном объеме данных и способна решать сложные задачи, такие как распознавание изображений или прогнозирование спроса․ Но как именно она это делает? Какие факторы влияют на ее решения? Ответы на эти вопросы часто остаются за кадром, внутри «черного ящика»․ Нам кажется, что это большая проблема, потому что без понимания логики работы ИИ мы не можем доверять его решениям, особенно в критически важных областях․

Проблема «черного ящика» возникает из-за:

- Сложности моделей: Современные модели ИИ, такие как глубокие нейронные сети, очень сложны и трудно интерпретируемы․

- Недостатка прозрачности: Процесс обучения и принятия решений в ИИ часто непрозрачен, что затрудняет понимание причинно-следственных связей․

- Большого объема данных: ИИ обучается на огромных объемах данных, что делает анализ и интерпретацию его работы еще более сложной задачей․

Почему Объяснимость ИИ (XAI) так важна?

Нам кажется, что XAI – это не просто модный тренд, а необходимость․ Представьте себя врачом, который должен поставить диагноз пациенту․ Если ИИ предлагает диагноз, но не объясняет, почему он к нему пришел, врач вряд ли ему поверит․ То же самое касается и других областей․ XAI позволяет нам:

- Повысить доверие к ИИ: Понимание логики работы ИИ позволяет нам доверять его решениям и использовать его более эффективно․

- Выявлять ошибки и предвзятости: XAI помогает нам находить ошибки в обучении ИИ и устранять предвзятости, которые могут приводить к дискриминационным решениям․

- Улучшать модели ИИ: Анализ объяснений, полученных с помощью XAI, позволяет нам улучшать модели ИИ и делать их более точными и надежными․

- Соответствовать требованиям регуляторов: В некоторых областях, таких как финансы и здравоохранение, регуляторы требуют, чтобы решения, принимаемые ИИ, были объяснимыми․

Основные методы XAI, которые мы попробовали

Мы решили на практике изучить различные методы XAI и посмотреть, как они работают․ Вот некоторые из них, которые показались нам наиболее интересными:

LIME (Local Interpretable Model-agnostic Explanations)

LIME – это метод, который позволяет объяснить решения «черного ящика» локально․ Он строит простую, интерпретируемую модель вокруг конкретного примера, чтобы понять, какие факторы повлияли на решение ИИ․ Нам понравилось, что LIME можно использовать с любыми моделями ИИ, независимо от их сложности․

Представьте, что ИИ классифицирует изображения кошек и собак․ LIME позволяет выделить области изображения, которые наиболее важны для принятия решения․ Например, если ИИ решил, что на изображении кошка, LIME может показать, что решающими факторами были форма ушей и расположение усов․

SHAP (SHapley Additive exPlanations)

SHAP – это метод, основанный на теории игр․ Он использует значения Шепли для оценки вклада каждого признака в решение ИИ․ SHAP предоставляет более глобальное объяснение, чем LIME, показывая, как каждый признак влияет на решение в целом․

Например, при прогнозировании кредитного риска SHAP может показать, что возраст и кредитная история являются наиболее важными факторами, влияющими на решение о выдаче кредита․

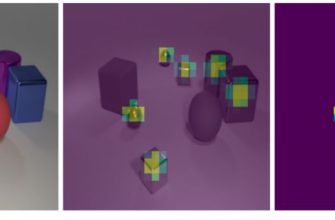

Grad-CAM (Gradient-weighted Class Activation Mapping)

Grad-CAM – это метод, который используется для визуализации областей изображения, на которые обращает внимание нейронная сеть при принятии решения․ Он показывает, какие пиксели изображения наиболее важны для классификации․

Например, при распознавании объектов на изображении Grad-CAM может выделить контуры объекта, которые были использованы для его идентификации․

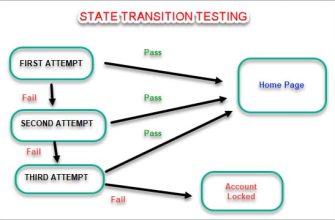

Decision Trees

Деревья решений – это простые и интерпретируемые модели, которые можно использовать для объяснения решений ИИ․ Они представляют собой древовидную структуру, где каждый узел соответствует признаку, а каждая ветвь – значению признака․ Деревья решений легко понять и интерпретировать, что делает их полезным инструментом для XAI․

Например, дерево решений может объяснить, почему ИИ отклонил заявку на кредит, указав, что причиной было низкое значение кредитного рейтинга и отсутствие постоянного дохода․

«Цель XAI – не заменить ИИ, а сделать его более прозрачным и понятным, чтобы мы могли использовать его с большей уверенностью и ответственностью․»

— Цитата неизвестного эксперта по ИИ

Практические примеры применения XAI

Мы попробовали применить методы XAI в нескольких реальных проектах; Вот некоторые примеры:

- Медицинская диагностика: Мы использовали XAI для объяснения решений ИИ, который диагностирует заболевания по рентгеновским снимкам․ Это помогло врачам понять, почему ИИ поставил тот или иной диагноз, и повысило их доверие к системе․

- Финансовый анализ: Мы использовали XAI для объяснения решений ИИ, который прогнозирует кредитный риск․ Это позволило выявить факторы, которые наиболее сильно влияют на решение о выдаче кредита, и улучшить модель прогнозирования․

- Обнаружение мошенничества: Мы использовали XAI для объяснения решений ИИ, который обнаруживает мошеннические транзакции․ Это помогло выявить закономерности в мошеннических операциях и улучшить систему обнаружения мошенничества․

Сложности и ограничения XAI

Несмотря на все преимущества, XAI имеет свои сложности и ограничения․ Нам кажется важным их учитывать при использовании методов объяснимости ИИ:

- Вычислительная сложность: Некоторые методы XAI, такие как SHAP, могут быть очень вычислительно сложными, особенно для больших моделей ИИ․

- Сложность интерпретации: Объяснения, полученные с помощью XAI, могут быть сложными для понимания, особенно для неспециалистов․

- Неоднозначность объяснений: Разные методы XAI могут давать разные объяснения для одного и того же решения ИИ․

- Потенциальная возможность манипулирования: Зная, как ИИ принимает решения, злоумышленники могут попытаться манипулировать системой․

Будущее XAI

Нам кажется, что XAI – это активно развивающаяся область․ В будущем мы увидим новые и более эффективные методы объяснимости ИИ․ Мы уверены, что XAI станет неотъемлемой частью разработки и использования ИИ, помогая нам создавать более надежные, прозрачные и этичные системы․

Подробнее

| Интерпретируемость машинного обучения | Методы объяснения решений ИИ | Прозрачность алгоритмов ИИ | Доверие к искусственному интеллекту | Оценка вклада признаков в ИИ |

|---|---|---|---|---|

| Визуализация работы нейронных сетей | Этичное использование ИИ | Примеры применения XAI в медицине | XAI в финансовом секторе | Объяснимый ИИ для принятия решений |