- Преодолевая Недоверие: Как Клиницисты Принимают Решения «Черного Ящика» в Эпоху ИИ

- Что такое «Черный Ящик» и Почему Он Вызывает Беспокойство?

- Примеры Проблем с «Черным Ящиком» в Медицине

- Почему Клиницисты Не Доверяют «Черным Ящикам»?

- Пути к Прозрачности и Объяснимости ИИ

- Конкретные Стратегии для Повышения Доверия

- Будущее Сотрудничества Человека и Машины

Преодолевая Недоверие: Как Клиницисты Принимают Решения «Черного Ящика» в Эпоху ИИ

В последнее время искусственный интеллект (ИИ) все глубже проникает в сферу здравоохранения, предлагая решения, которые раньше казались научной фантастикой. Мы, как наблюдатели и участники этого процесса, видим, как алгоритмы машинного обучения анализируют медицинские изображения, предсказывают риски заболеваний и даже помогают в разработке новых лекарств. Однако, вместе с обещаниями революции в медицине, приходит и вызов – как клиницистам доверять решениям «черного ящика», алгоритмам, чья внутренняя работа остается непрозрачной?

Эта статья – попытка разобраться в сложностях, связанных с принятием решений ИИ в клинической практике. Мы рассмотрим причины недоверия, обсудим способы повышения прозрачности и объяснимости ИИ, а также предложим стратегии для эффективного сотрудничества человека и машины.

Что такое «Черный Ящик» и Почему Он Вызывает Беспокойство?

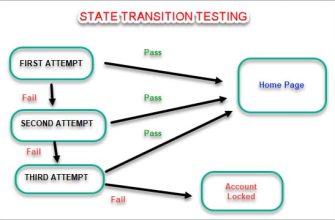

Термин «черный ящик» описывает системы, чьи внутренние механизмы принятия решений остаются скрытыми от пользователя. В контексте ИИ это означает, что клиницист может видеть только входные данные и выходной результат, но не понимает, как именно алгоритм пришел к этому выводу. Например, ИИ может выдать диагноз «пневмония» на основе рентгеновского снимка, но не объяснять, какие именно признаки на изображении привели к такому заключению.

Такая непрозрачность вызывает ряд серьезных опасений:

- Отсутствие подотчетности: Если алгоритм совершает ошибку, трудно определить, кто несет ответственность – разработчик, пользователь или сам алгоритм?

- Возможность предвзятости: Алгоритмы обучаются на данных, которые могут содержать скрытые предубеждения. Это может привести к тому, что ИИ будет принимать дискриминационные решения в отношении определенных групп пациентов.

- Сложность верификации: Клиницистам сложно проверить правильность решения «черного ящика», особенно если они не обладают глубокими знаниями в области машинного обучения.

- Этические дилеммы: Непрозрачность ИИ может затруднить соблюдение этических принципов медицины, таких как информированное согласие и конфиденциальность.

Примеры Проблем с «Черным Ящиком» в Медицине

Рассмотрим несколько конкретных примеров, иллюстрирующих проблемы, связанные с использованием «черных ящиков» в медицинской практике:

- Диагностика рака кожи: ИИ может превосходить врачей в выявлении рака кожи по изображениям, но если он не объясняет свои выводы, клиницист не может оценить надежность диагноза и принять обоснованное решение о лечении.

- Прогнозирование рисков: Алгоритмы могут предсказывать риск развития заболеваний, таких как сердечно-сосудистые заболевания или диабет. Однако, если они не раскрывают факторы, которые влияют на прогноз, пациенты могут не понимать, как им изменить свой образ жизни для снижения риска.

- Назначение лекарств: ИИ может рекомендовать оптимальную дозировку лекарств на основе индивидуальных характеристик пациента. Но если он не объясняет, почему он выбрал именно эту дозу, врачи могут опасаться назначать ее, особенно если она отличается от стандартной.

Почему Клиницисты Не Доверяют «Черным Ящикам»?

Доверие – ключевой фактор в отношениях между врачом и пациентом. Клиницисты должны быть уверены в том, что они принимают обоснованные и безопасные решения. Непрозрачность «черных ящиков» подрывает это доверие по нескольким причинам:

- Отсутствие понимания: Врачи хотят понимать, как работает инструмент, который они используют. Если они не понимают логику работы алгоритма, им трудно доверять его решениям.

- Страх ошибок: Врачи несут ответственность за здоровье своих пациентов. Они опасаются, что «черный ящик» может совершить ошибку, которая приведет к негативным последствиям.

- Потеря контроля: Использование ИИ может восприниматься как потеря контроля над процессом принятия решений. Врачи хотят сохранять свою автономию и принимать решения на основе своего опыта и знаний.

- Этические соображения: Врачи обеспокоены тем, что использование «черных ящиков» может привести к нарушению этических принципов медицины, таких как справедливость и конфиденциальность.

«Искусственный интеллект не заменит врачей, но врачи, использующие искусственный интеллект, заменят тех, кто его не использует.» ― Д-р Эрик Тополь

Пути к Прозрачности и Объяснимости ИИ

Чтобы завоевать доверие клиницистов, необходимо сделать ИИ более прозрачным и объяснимым. Существует несколько подходов к достижению этой цели:

- Объяснимый ИИ (XAI): XAI – это область исследований, направленная на разработку алгоритмов, которые могут объяснять свои решения. Существуют различные методы XAI, такие как визуализация, выделение важных признаков и генерация текстовых объяснений.

- Прозрачные модели: Некоторые модели машинного обучения, такие как деревья решений и линейные модели, по своей природе более прозрачны, чем другие, такие как нейронные сети. Использование прозрачных моделей может облегчить понимание логики работы алгоритма.

- Аудит и валидация: Независимые эксперты должны проводить аудит и валидацию алгоритмов ИИ, чтобы убедиться в их надежности и отсутствии предвзятости.

- Обучение и образование: Клиницисты должны получать образование в области ИИ, чтобы понимать его возможности и ограничения. Это поможет им более уверенно использовать ИИ в своей практике.

Конкретные Стратегии для Повышения Доверия

Вот несколько конкретных стратегий, которые могут помочь клиницистам доверять решениям «черного ящика»:

- Использовать ИИ как инструмент поддержки, а не замены: ИИ должен помогать врачам принимать решения, а не заменять их. Врачи должны сохранять свою критическую оценку и принимать окончательные решения на основе своего опыта и знаний.

- Требовать объяснений: Клиницисты должны требовать от разработчиков ИИ объяснений, почему алгоритм принял то или иное решение. Если объяснения непонятны или неубедительны, они должны отказаться от использования этого алгоритма.

- Проверять результаты: Клиницисты должны проверять результаты, выдаваемые ИИ, на соответствие клинической картине пациента. Если результаты кажутся нелогичными или противоречивыми, они должны провести дополнительное обследование.

- Сообщать об ошибках: Клиницисты должны сообщать разработчикам ИИ об ошибках, которые они обнаруживают. Это поможет улучшить алгоритмы и предотвратить повторение ошибок в будущем.

Будущее Сотрудничества Человека и Машины

В конечном счете, будущее медицины – это сотрудничество между врачами и ИИ. Врачи должны использовать ИИ как мощный инструмент, который может помочь им принимать более обоснованные и эффективные решения. В то же время, они должны сохранять свою критическую оценку и не забывать о человеческом факторе в медицине.

Мы видим, что преодоление недоверия к «черным ящикам» – это сложный, но необходимый процесс. Он требует усилий как от разработчиков ИИ, так и от клиницистов. Только совместными усилиями мы сможем реализовать потенциал ИИ для улучшения здоровья и благополучия людей.

Подробнее

| LSI Запрос 1 | LSI Запрос 2 | LSI Запрос 3 | LSI Запрос 4 | LSI Запрос 5 |

|---|---|---|---|---|

| доверие к ии в медицине | проблемы черного ящика | объяснимый ии в здравоохранении | ии в диагностике | этика ии в медицине |

| внедрение ии в клиническую практику | риски использования ии в медицине | прозрачность ии | алгоритмическая предвзятость в медицине | обучение врачей ии |