- Предвзятые алгоритмы: Скрытая угроза нашего цифрового будущего

- Что такое предвзятость алгоритмов и почему она возникает?

- Примеры предвзятости алгоритмов в реальной жизни

- Последствия предвзятости алгоритмов

- Что можно сделать для решения проблемы предвзятости алгоритмов?

- Роль разработчиков, компаний и государства

- Разработчики

- Компании

- Государство

- Будущее алгоритмов: На пути к справедливости

Предвзятые алгоритмы: Скрытая угроза нашего цифрового будущего

Мы живем в эпоху алгоритмов. Они управляют нашей жизнью больше, чем мы осознаем: от рекомендаций фильмов и музыки до решений о выдаче кредитов и даже приговоров в суде. Но что происходит, когда эти алгоритмы предвзяты? Когда в их коде заложена дискриминация, приводящая к несправедливым и даже опасным последствиям?

В этой статье мы погрузимся в мир предвзятых алгоритмов, рассмотрим причины их возникновения, примеры их проявления в различных сферах жизни и, самое главное, обсудим, что мы можем сделать для решения этой проблемы. Приготовьтесь к путешествию вглубь цифровой предвзятости – проблеме, которая касается каждого из нас.

Что такое предвзятость алгоритмов и почему она возникает?

Предвзятость алгоритмов – это систематическая и повторяющаяся ошибка в компьютерной системе, которая создает несправедливые результаты, такие как дискриминация определенных групп людей. Эти ошибки могут быть вызваны различными факторами, часто неочевидными на первый взгляд.

Одной из основных причин является предвзятость в данных. Алгоритмы обучаются на данных, и если эти данные отражают существующие в обществе предубеждения и стереотипы, алгоритм их усвоит и воспроизведет. Например, если алгоритм, предназначенный для отбора кандидатов на работу, обучается на данных, где в основном представлены мужчины на руководящих должностях, он может начать отдавать предпочтение мужчинам, даже если женщины обладают равными или лучшими квалификациями.

Другой причиной является предвзятость в дизайне алгоритма. Разработчики, сами того не подозревая, могут заложить в алгоритм свои собственные предубеждения и ценности. Например, при разработке алгоритма для оценки кредитоспособности разработчик может неосознанно придать больший вес определенным факторам, таким как место жительства, что может привести к дискриминации жителей определенных районов.

Наконец, предвзятость может возникать из-за неполноты или отсутствия данных. Если в наборе данных недостаточно информации о какой-либо группе людей, алгоритм может сделать неправильные выводы о ней. Например, если алгоритм для распознавания лиц обучается в основном на фотографиях людей европеоидной расы, он может плохо распознавать лица людей других рас.

Примеры предвзятости алгоритмов в реальной жизни

К сожалению, примеры предвзятости алгоритмов встречаются повсеместно. Вот лишь несколько из них:

- Системы распознавания лиц: Как уже упоминалось, эти системы часто показывают худшие результаты при распознавании лиц людей с темной кожей, особенно женщин. Это может приводить к ложным обвинениям и несправедливым арестам.

- Алгоритмы подбора персонала: Некоторые компании используют алгоритмы для автоматической фильтрации резюме. Если эти алгоритмы обучаются на предвзятых данных, они могут отсеивать квалифицированных кандидатов из недопредставленных групп.

- Системы оценки кредитоспособности: Алгоритмы, используемые для оценки кредитного риска, могут дискриминировать людей с низким доходом или живущих в определенных районах, даже если они имеют хорошую кредитную историю.

- Рекомендательные системы: Алгоритмы, предлагающие нам фильмы, музыку и товары, могут формировать «пузырь фильтров», ограничивая наш кругозор и усиливая существующие предубеждения.

Эти примеры показывают, что предвзятость алгоритмов – это не просто теоретическая проблема. Она оказывает реальное влияние на жизни людей, ущемляя их права и возможности.

Последствия предвзятости алгоритмов

Последствия предвзятости алгоритмов могут быть разрушительными. Они включают:

- Дискриминацию: Алгоритмы могут усиливать существующие формы дискриминации по признаку расы, пола, возраста, религии и других характеристик.

- Несправедливость: Предвзятые алгоритмы могут приводить к несправедливым решениям в таких областях, как трудоустройство, кредитование, образование и правосудие.

- Усиление неравенства: Предвзятость алгоритмов может усугублять неравенство в обществе, ограничивая возможности для определенных групп людей.

- Потерю доверия: Если люди теряют доверие к алгоритмам, они могут отказываться от их использования, что замедляет прогресс и инновации.

Важно понимать, что предвзятость алгоритмов – это не просто случайные ошибки. Это систематические проблемы, которые требуют серьезного внимания и целенаправленных усилий для их решения.

«Технологии – это зеркало. Они отражают наши ценности и наши недостатки. Если мы хотим, чтобы технологии были справедливыми, мы должны сначала стать справедливыми сами.» ― Кэти О’Нил, автор книги «Оружие математического уничтожения»

Что можно сделать для решения проблемы предвзятости алгоритмов?

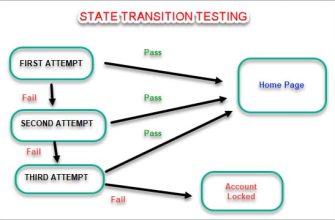

Решение проблемы предвзятости алгоритмов – это сложная задача, требующая комплексного подхода. Вот некоторые шаги, которые мы можем предпринять:

- Повышение осведомленности: Важно, чтобы люди понимали, что такое предвзятость алгоритмов и как она может влиять на их жизнь.

- Сбор и анализ данных: Необходимо собирать более полные и репрезентативные данные, отражающие разнообразие общества.

- Разработка более справедливых алгоритмов: Разработчики должны использовать методы, позволяющие выявлять и устранять предвзятость в алгоритмах.

- Прозрачность и подотчетность: Алгоритмы должны быть прозрачными, чтобы люди могли понимать, как они работают и какие факторы влияют на принимаемые решения.

- Регулирование: Необходимы законы и нормативные акты, регулирующие использование алгоритмов и защищающие людей от дискриминации.

Роль разработчиков, компаний и государства

Каждый из нас играет важную роль в борьбе с предвзятостью алгоритмов:

Разработчики

Разработчики несут особую ответственность за создание справедливых и непредвзятых алгоритмов. Они должны:

- Осознавать свои собственные предубеждения и стараться их избегать.

- Использовать разнообразные наборы данных для обучения алгоритмов.

- Тестировать алгоритмы на различных группах людей, чтобы выявить возможную дискриминацию.

- Сделать алгоритмы прозрачными и понятными для пользователей.

Компании

Компании, использующие алгоритмы, должны:

- Проводить регулярные проверки алгоритмов на предвзятость.

- Обучать своих сотрудников принципам этичного использования алгоритмов.

- Разрабатывать механизмы для исправления ошибок и компенсации ущерба, причиненного предвзятыми алгоритмами.

Государство

Государство должно:

- Принимать законы и нормативные акты, регулирующие использование алгоритмов.

- Создавать независимые органы для контроля за соблюдением этих правил.

- Поддерживать исследования в области этики и справедливости алгоритмов.

Будущее алгоритмов: На пути к справедливости

Предвзятость алгоритмов – это серьезная проблема, но она не является непреодолимой. Благодаря совместным усилиям разработчиков, компаний, государства и всего общества мы можем создать более справедливые и этичные алгоритмы, которые будут служить интересам всех людей.

Важно помнить, что алгоритмы – это всего лишь инструменты. Они могут быть использованы как для добра, так и для зла. От нас зависит, как мы будем их использовать. Мы должны стремиться к тому, чтобы алгоритмы стали союзниками в борьбе за справедливость и равенство, а не орудиями дискриминации и угнетения.

Подробнее

| Предвзятость в машинном обучении | Алгоритмическая дискриминация | Этика искусственного интеллекта | Справедливость алгоритмов | Устранение предвзятости в данных |

|---|---|---|---|---|

| Последствия предвзятых алгоритмов | Ответственность разработчиков ИИ | Прозрачность алгоритмов | Регулирование искусственного интеллекта | Примеры предвзятых алгоритмов |